เราต่างรู้ว่า ChatGPT ไม่ได้พูด "ความจริง"

ในปีที่เราต่างเฉลิมฉลองความสำเร็จของเทคโนโลยีปัญญาประดิษฐ์จนนำมาสู่คำถามต่อประเด็นดังกล่าวอย่างกว้างขวางและแพร่หลาย แต่สิ่งที่น่ากลัวที่สุดไม่ใช่เรื่องที่มันจะเข้ามาแทรกแซงหรือปกครองมนุย์

ถ้าพูดถึง AI ที่ฮิตที่สุดในเวลานี้คงไม่มีใครปฏิเสธชื่อของ ChatGPT จาก OpenAI ไปได้ เรียกว่าเป็น AI ที่สร้างความฮือฮาให้สังคมอย่างต่อเนื่องไม่หยุดหย่อนตั้งแต่เปิดตัวมา แถมกำลังจะเปิดตัวเวอร์ชัน 4 ที่จะสามารถประมวลภาพเคลื่อนไหวและเสียงได้จนอาจจะสร้างหนังสั้นผ่าน ChatGPT ได้เลยในอนาคต

ลำพังตัวที่เป็น text-based ของ ChatGPT ก็ป่วนโลกจนแทบจะรับมือไม่ไหวกันแล้ว ถึงขนาดมีสำนักพิมพ์ที่ยกเลิกการประกวดเพราะสงสัยว่าผู้ส่งจะใช้ ChatGPT ในการเขียน ลามไปถึงเรื่องเล็ก ๆ น้อย ๆ อย่างการ “ส่งการบ้าน” ของนักเรียนที่มักพึ่งพา ChatGPT ให้ช่วยทำจนอาจารย์หลายคนต้องหาทางรับมือกันจนปวดหัว

ความเก่งกาจของเจ้า ChatGPT นี้เองที่ทำให้สังคมเริ่มเทความสนใจไปในทาง “พ่อหมอ” ที่นึกไม่ออกคิดไม่ตกก็เรียกใช้ความช่วยเหลือจาก ChatGPT เริ่มจากงานที่มั่นใจว่า AI น่าจะทำได้อย่างการเขียนโค้ดโปรแกรม ก่อนจะลากยาวไปถึงปัญหาชีวิตและประเด็นสังคมต่าง ๆ และหลายต่อหลายครั้งก็นำมาพูดถึงกันราวกับว่านี่เป็น “คำตอบที่ถูกต้อง” เพราะมาจากปัญญาประดิษฐ์ที่รอบรู้กว่าอับดุลก็ไม่ปาน

แต่ ChatGPT ไม่ได้พูด “ความจริง”

นี่ไม่ใช่เพียงคำที่คิดขึ้นมาลอย ๆ

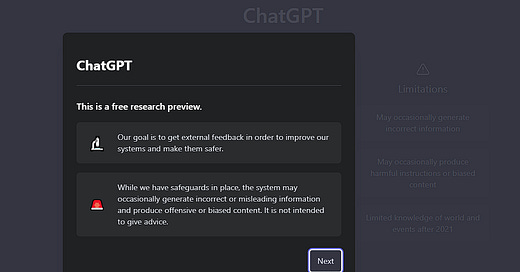

หากใครได้มีโอกาสลองเข้าไปเล่น ChatGPT เราจะพบการแจ้งเตือนตั้งแต่เนิ่น ๆ เลยว่าข้อความที่ออกมาอาจจะ “ไม่ถูกต้อง” และ “ให้ข้อมูลผิดพลาด” ได้

หมายความว่าแม้แต่ผู้สร้างเองก็เข้าใจ “ข้อจำกัด” ณ จุดนี้ของ ChatGPT และได้มีการแจ้งเตือนไว้ตั้งแต่ก่อนเริ่มใช้งาน เท่ากับว่าเราทุกคนที่ใช้ ChatGPT ต่างต้องรู้ข้อจำกัดนี้อยู่แล้วตั้งแต่ต้นว่าสิ่งที่ ChatGPT ประมวลมาให้นั้น “ไม่ใช่ความจริง” อย่างแน่นอน

ยิ่งไปกว่านั้นถ้าให้พูดถึงหลักการทำงาน machine learning แบบง่าย ๆ ก็คือต้องมีการ “ป้อนข้อมูล” เพื่อให้ AI จดจำและนำไปประมวลผลได้ ซึ่งก็จะกลับมาที่คำถามว่า แล้วอะไรบ้างที่ถูกป้อนเข้าไปใน ChatGPT เป็นข้อมูลแบบไหน น่าเชื่อถือระดับไหน ตื้นลึกหนาบางและรอบด้านขนาดไหน อ้างอิงด้วยหลักคิด วิธีการ และแนวทางทางปรัชญาแบบใด ซึ่งพอถามกันในระดับนี้เราจะพบว่าจริง ๆ แล้ว ChatGPT เป็นเพียงระบบบันทึกข้อมูลและประมวลผลคำตอบตามแนวทางที่ถูกบันทึกไว้เท่านั้น

ซึ่งถ้าพูดแบบอภิปรัชญาให้ฟังยาก ๆ ไปเลยก็ต้องถามว่า “แล้วเราจะรู้ได้ไงว่าสิ่งที่ป้อนไปเป็นความจริง”

“ข้อเท็จจริง” ไม่เท่ากับ “ความจริง”

สิ่งที่ ChatGPT ทำได้ดีและแม่นยำมาก ๆ คือข้อมูลที่เป็นเชิง “ข้อเท็จจริง” อะไรที่มีระบบ หรือถูกป้อนระบบในการ “ตรวจสอบ” ว่าเป็น “จริงหรือเท็จ” เข้าไปด้วย เช่น การคำนวณ การเขียนโปรแกรม เป็นต้น

แต่ในข้อมูลที่เป็น “ข้อถกเถียง” เราจะพบว่า ChatGPT มีปัญหาในการอธิบายอย่างมาก ในระดับที่หากนี่เป็นการบ้านวิชาเรียนในมหาวิทยาลัย ChatGPT อาจจะได้ 0 หรือติด F ได้ง่าย ๆ

ยกตัวอย่างเช่น ล่าสุด ในบทความของทาง Spaceth.co ที่ได้ท้าทาย ChatGPT ให้อธิบายว่า “ทำไมบางคนถึงเชื่อว่า NASA ไม่เคยไปดวงจันทร์” หากเราอ่านมันอย่างผิวเผิน เราคงรู้สึกว่ามันก็ “make sense” ดี หรือเขียนได้ดีในระดับหนึ่ง

แต่หากมองในรายระเอียดเราจะพบว่าคำอธิบายของ ChatGPT นั้น “ผิวเผิน” มาก

และนี่ไม่ใช่ครั้งแรก เพราะหากย้อนกลับไปดูเหล่าผู้คนที่ต้องการ “ตรวจสอบ” ความแม่นยำของ ChatGPT เราจะพบว่าแทบทุกครั้ง ChatGPT ขาดความสามารถในการอธิบายอย่าง “เจาะจง” คือหากให้กล่าวแบบคร่าว ๆ ผิว ๆ โดยไม่ลงรายละเอียดนั้นเราจะพบว่าการตอบของ ChatGPT ลื่นไหลและดู “น่าเชื่อถือ” ทั้งที่จริง ๆ แล้วข้อมูลที่ประมวลมาแทบไม่ได้มี “หลักฐานสนับสนุน” สิ่งที่ตัวเองตอบมากเท่าที่ควร

ถ้าให้ลองนึกภาพตาม จะนึกถึงการทำรายงานสมัยมัธยม ที่เรามักใช้คำกว้าง ๆ ที่ “ดูเหมือนจะถูกต้อง” ในการอธิบาย เช่น ทำไมน้ำท่วม เพราะการบริหารจัดการน้ำไม่ดี เพราะประเทศไทยมีฝนตกชุกเลยทำให้มีปริมาณน้ำมากเป็นปกติ หรือคนสร้างบ้านตามทางน้ำทำให้เมื่อน้ำตามธรรมชาติไหลมาจึงเกิดเป็นน้ำท่วมทั้งที่เป็นภาวะปกติ

ถามว่าถ้าอธิบายแค่นี้ผิดไหม คำตอบคือ “ไม่ผิด” แต่มันก็ “ไม่ได้มีความหมาย” ในการอธิบาย คือแล้วบริหารจัดการน้ำไม่ดียังไง นโยบายไหนที่เป็นปัญหา หรือตรงจุดไหนที่เป็นปัจจัยส่งเสริมการเกิดน้ำท่วม ประเทศไทยมีปริมาณน้ำเยอะแค่ไหน และไหลผ่านช่องทางไหนเป็นปกติ พื้นที่ที่น้ำท่วมมันเคยท่วมมาก่อนมีคนมาสร้างบ้านเรือนไหม หรือสร้างแล้วค่อยท่วม หรือสร้างตอนแรกแล้วไม่ท่วม แต่พอมีถนนหรือเขื่อนสร้างใกล้ ๆ ถึงเริ่มท่วม

สิ่งเหล่านี้ถ้าเราตั้งคำถามกับมันว่า “จริงไหม” เราอาจจะพบว่าจริง ๆ แล้วคำอธิบาย “กว้าง ๆ” เหล่านั้นอาจจะ “ผิดพลาด” และ “สร้างความเข้าใจผิดทางข้อมูล” ได้ด้วยซ้ำ คือพอไปดูข้อมูลจริง ๆ อาจจะไม่ใช่เรื่องบริหารผิดพลาด แต่เกิดจากปรากฏการณ์โลกรวน หรืออาจจะเกิดจากการแทรกแซงของกลุ่มทุนที่ทำให้พื้นที่ทรัพยากรหดหายจนเกิดน้ำท่วม จริง ๆ แล้วพื้นที่ที่ชาวบ้านสร้างก็อาจจะอยู่นอกพื้นที่น้ำหลาก (flood plain) แล้ว แต่เพราะมีโครงการเขื่อนจากต่างประเทศปล่อยน้ำปริมาณ “ผิดธรรมชาติ” จนพื้นที่น้ำหลากมันขยายเพิ่มขึ้น

ลองนึกเล่น ๆ ว่าถ้าสิ่งเหล่านี้ถูกเขียนด้วย “คน” ในโพสต์อย่างไม่เป็นทางการตามโซเชียลมีเดีย ต้องมีคนจำนวนไม่น้อยที่รู้สึกสงสัยว่ามัน “จริงไหม”

แต่พอเป็น ChatGPT เรากลับทำเหมือนว่า “ไม่จำเป็นต้องตรวจสอบก็ได้” ในลักษณะเดียวกับ “การเอนเอียงต่อความคิดของตนแต่เพียงผู้เดียว (Confirmation Bias)” จากกรณีเชื่อว่า NASA ไม่เคยไปดวงจันทร์นั่นแหละ

และด้วยปัจจุบันที่คนเริ่มใช้ ChatGPT ในหลากหลายเป้าหมายทั้งที่ผู้สร้างยืนยันว่าตัว AI ไม่ได้ถูกออกแบบมาเพื่อ “ให้คำแนะนำ” บ้างก็ใช้เป็นแหล่งอ้างอิง (Reference) แบบทื่อ ๆ โดยไม่มีการอ้างอิงแหล่งข้อมูลยืนยันหรือตรวจสอบ

คำถามที่น่าสนใจจึงเป็นว่าเรา “ระแวดระวัง” กันมากน้อยแค่ไหนในเงื่อนไขที่ “ChatGPT ไม่ได้พูดความจริง”

สิ่งที่ “น่ากังวล” ในกรณีของ AI และ Machine Learning จึงไม่ใช่เรื่องของการที่สิ่งเหล่านี้จะเข้ามาแทนที่มนุษย์ หรือปกครองมนุษย์ตามแบบนิยายวิทยาศาสตร์เคยคาดการณ์ แต่กลับเป็นเรื่องง่าย ๆ ที่ว่า

มนุษย์เรามีวิจารณญาณแค่ไหน ในการจะแยกแยะ “ความจริง” ออกจาก “ข้อมูล” หรือ “ข้อเท็จจริง”

เพราะเมื่อใดก็ตามที่เรายึดโยง “ข้อมูล” หรือ “ข้อเท็จจริง” ใด ๆ เป็น “ความจริงแท้” ที่ไม่ควรถูกละเมิด หมายความว่าเราเองก็เป็นแค่ “คนที่เชื่อว่า NASA ไม่เคยไปดวงจันทร์” ในอีกรูปแบบหนึ่งเท่านั้นเอง